Dans la vraie vie, choisir une solution BI ne consiste pas à prendre le logiciel le plus connu du marché. Il s’agit surtout d’aligner trois éléments qui vont toujours ensemble : les décisions, les données et la gouvernance.

Une business intelligence efficace vous aide à trancher plus vite, avec des indicateurs partagés et compréhensibles. Un mauvais choix, au contraire, vous renvoie rapidement vers des exports manuels, des fichiers Excel et des débats sans fin sur les chiffres.

Chez Eulidia, nous le constatons sur des programmes data d’entreprise de toute taille : un logiciel BI adapté fait gagner du temps à tous les niveaux. À l’inverse, un outil mal choisi fragilise l’architecture BI et ralentit la prise de décision.

Soyons clairs dès le départ : il n’existe pas de “meilleure solution BI” universelle. Une startup data first, un groupe multi pays ou une organisation fortement réglementée n’ont ni les mêmes contraintes, ni les mêmes risques. L’objectif de cet article n’est donc pas de vendre un outil, mais de vous donner une grille de lecture solide, puis un comparatif BI utile entre Sigma, Qlik, Metabase, Tableau et Power BI.

Eléments de décision : partir des besoins métier, sinon les outils choisissent pour vous

Avant d’ouvrir un tableau comparatif ou de tester un outillage BI, posez une question simple : qu’est ce qu’on doit piloter, exactement ?

L’analytics ne se résumet pas à un concours de dashboards. C’est la capacité à relier une métrique à une action, puis à une décision. Si cette chaîne n’est pas claire, même un excellent logiciel BI ne fera pas de miracle.

Intégration dans vos workflows : qui consomme quoi, et où ?

Le sujet n’est pas seulement de connecter des sources de données, mais bien de connecter des usages. Vos équipes consultent-elles leurs indicateurs dans Teams, dans un portail interne ou en réunion de direction ? Vos opérationnels ont-ils besoin d’un tableau de bord mobile ? Vos analystes doivent-ils explorer et expliquer, ou simplement diffuser des rapports ?

Ces questions sont centrales lorsqu’on choisit les outils BI. Elles structurent l’architecture BI autant que le choix du logiciel BI lui-même.

C’est précisément ce type de cadrage que l’on retrouve dans une démarche de data stratégie : faire émerger les usages prioritaires, définir une gouvernance claire et passer du reporting de masse au pilotage de la performance.

Temps réel ou reporting différé : le faux débat qui coûte cher

Le temps réel est souvent demandé par réflexe. Pourtant, le besoin réel est fréquemment ailleurs : un rafraîchissement plus fréquent ou un meilleur suivi des alertes. La bonne question est simple : quel est l’impact business si la donnée a vingt quatre heures de retard ?

Si la réponse est “aucun”, vous économisez beaucoup de complexité technique.

Le temps réel souvent implique plus de contrôles, plus de tests et une chaîne plus fragile. À l’inverse, un reporting quotidien, bien gouverné, peut déjà transformer la prise de décision. Et c’est un point clé lorsqu’on prépare des usages avancés, notamment en IA : vos métriques doivent être stables, pas recalculées différemment à chaque usage.

Expérience utilisateur : autonomie oui, anarchie non

Un utilisateur métier veut explorer les données sans écrire du SQL à chaque clic. C’est légitime. Mais le self service ne signifie pas l’absence de règles. Sans modèle sémantique, sans définitions partagées de KPI et sans gestion des droits, vous créez une divergence structurelle.

Un test simple permet de le vérifier : demandez à deux équipes de calculer le “revenu net” dans l’outil.

Si vous obtenez deux réponses différentes, le problème n’est pas l’outil BI. C’est la gouvernance. Et aucun intégrateur BI ne pourra compenser durablement ce manque sans un cadrage clair en amont.

Critères techniques : éviter le “ça marchait en démo” et sécuriser le passage à l’échelle

Les outils BI se ressemblent souvent quand on clique sur des exemples ou des jeux de données de démonstration. Ils se différencient réellement lorsqu’il faut gérer cinq cents utilisateurs, des données sensibles et des contraintes de conformité.

Dans une grande entreprise, les critères techniques ne sont pas une simple checklist IT. Ce sont des garde-fous qui protègent votre capacité à décider vite, sans mettre en risque l’organisation.

Autrement dit, ce qui semble accessoire en phase de test devient structurant dès que la BI passe à l’échelle.

Connectivité, modèles et sources de données

La première étape consiste à cartographier vos sources de données réelles : bases SQL, data warehouse, API, fichiers plats. Certains outils BI sont très à l’aise dans un modèle warehouse first, où tout est centralisé. D’autres tolèrent mieux une donnée plus distribuée, au prix d’une gouvernance plus exigeante.

Un point clé à examiner est la réutilisation des modèles et des métriques. L’outil permet-il de partager un modèle sémantique commun, ou oblige-t-il à dupliquer les calculs rapport par rapport ?

C’est un critère déterminant dès lors que l’on cherche à industrialiser le reporting, à stabiliser les indicateurs et à limiter la dette analytique.

Gouvernance, sécurité, droits : l’outil analytics n’est pas un simple écran

Dès que des données clients, financières ou RH sont exposées, la question devient immédiatement : qui voit quoi, et pour quelle raison ?

Les mécanismes de contrôle d’accès, de rôles, d’audit et de partage externe ne sont pas optionnels. Ils conditionnent la confiance dans le logiciel BI autant que son adoption.

Sur le plan réglementaire, le RGPD fixe un cadre clair : minimisation des données, sécurité, protection dès la conception. S’appuyer sur le texte officiel permet d’éviter des interprétations approximatives et des décisions prises “au feeling”.

Pour structurer une approche sécurité solide, deux références sont fréquemment utilisées dans les grands groupes : ISO IEC 27001, qui définit un cadre de management de la sécurité, et NIST SP 800 53, qui propose un catalogue de contrôles de sécurité et de protection de la vie privée. Ces référentiels n’imposent pas un outil, mais des exigences que votre architecture BI doit pouvoir respecter.

Performance, scalabilité, coût total : la licence n’est qu’un morceau du puzzle

Le coût total de possession d’un outil BI ne se résume jamais à un prix par utilisateur. Il inclut aussi :

- le temps de modélisation,

- la maintenance des applications,

- l’effort de gouvernance,

- la formation des équipes,

- et la capacité à industrialiser dans la durée.

Dans les trajectoires de transformation data, l’enjeu n’est pas de tout faire d’un coup, mais d’organiser l’effort. Diagnostic, feuille de route, plateforme, data factory, montée en maturité et autonomie s’enchaînent dans le temps.

Un bon choix de solution BI est celui qui accompagne cette progression, sans créer de rupture à chaque nouvelle étape.

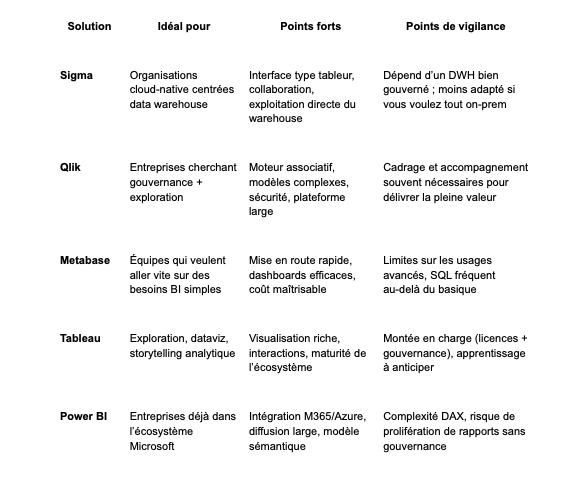

Solutions BI : comparatif Sigma, Qlik, Metabase, Tableau, Power BI

On passe au concret. Voici une lecture terrain : pour quel type d’usage chaque solution BI est réellement pertinente, et où se situent les pièges. Ce comparatif n’a de valeur que replacé dans votre contexte : cloud ou on prem, exigences de sécurité, volumétrie, profils utilisateurs et niveau de maturité data.

Sigma : logique “tableur” sur un warehouse moderne

Sigma Computing parle immédiatement aux organisations qui ont déjà investi dans un data warehouse moderne et qui veulent retrouver la simplicité d’un tableur, sans retomber dans le chaos des fichiers Excel échangés par mail.

Le principe est direct : Sigma se connecte à votre base cloud et exécute les requêtes au plus près des données, puis expose le résultat dans une interface web qui reprend les codes du tableur, mais dans un cadre collaboratif et gouverné.

Pour les équipes métier, l’impact est réel. On conserve le confort du tableur tout en restant dans une architecture BI propre. Ce qui séduit, c’est la fluidité : filtrer, regrouper, calculer, commenter, partager, sans transformer chaque question en ticket data.

Dans les grands comptes, Sigma fonctionne particulièrement bien lorsque les métriques sont déjà gouvernées : modèle clair dans le warehouse, définitions stables, règles de droits explicites. À l’inverse, si l’entrepôt est fragile ou mal documenté, l’outil ne masque rien. Il révèle le problème. La BI ne compense pas durablement un modèle bancal.

Là où Sigma est très fort (et pourquoi)

- Adoption rapide côté métier : prise en main intuitive pour des profils finance, ops ou commerce

- Collaboration native : travail à plusieurs sur les mêmes vues, fin des versions “v1_final_final.xlsx”

- Approche warehouse first : capitalisation sur Snowflake, BigQuery, Databricks ou Redshift, sans duplication inutile de données

Points à surveiller (les vraies questions, pas la brochure)

- Dépendance à la maturité data : des KPI mal définis accélèrent surtout la divergence

- Cas d’usage hors warehouse : données on prem ou très dispersées moins bien couvertes

- Gouvernance : qui valide les métriques, qui publie, qui possède le catalogue ? Sigma n’est pas un substitut à la data governance

Conformité et vendor assessment

Côté sécurité, Sigma centralise ses éléments de confiance dans un Trust Center incluant rapports SOC et certifications ISO. Un point clé pour fluidifier les processus de vendor assessment dans les grandes entreprises, où les équipes risk et conformité interviennent très tôt.

Qlik : gouvernance et exploration associative

Qlik se distingue dans des contextes d’entreprise typiques : données hétérogènes, modèles complexes, multiples entités et demandes analytiques évolutives.

Là où certains outils imposent un chemin strict “modèle puis dashboard”, Qlik met en avant une exploration associative plus libre, sans rompre la cohérence, à condition d’un cadrage solide.

C’est souvent un choix pertinent pour les organisations qui veulent démocratiser l’analyse tout en conservant des garde fous. En pratique, Qlik répond bien aux environnements où cohabitent consommateurs de reporting, explorateurs métier, power users et une équipe centrale responsable du décisionnel. (help.qlik.com)

Là où Qlik est très fort

- Modèles de données complexes avec relations multiples et périmètres variables

- Gouvernance à l’échelle : droits, cohérence, contrôle et structuration du décisionnel

- Déploiement international avec options de régions cloud pour les enjeux de résidence des données ou de latence.

Points à surveiller

- Le cadrage initial : trop de liberté trop tôt peut nuire à la lisibilité

- La conduite du changement : l’exploration associative se forme, sinon chacun “voit ce qu’il veut”

- L’architecture des apps et espaces : sans règles, les doublons s’accumulent rapidement.

Conformité et “data residency”

Qlik documente de façon détaillée ses dispositifs de sécurité, conformité et privacy, avec des options de régions cloud adaptées aux organisations multi pays. Un critère souvent décisif en comité de direction.

Metabase : simplicité assumée, efficace sur le quotidien

Metabase est fréquemment choisi pour une raison simple : la vitesse. On connecte une base, on pose des questions, on publie des dashboards. Pour des équipes agiles ou des organisations souhaitant sortir du reporting artisanal, l’outil est très efficace sur le quotidien.

Il y a aussi un effet psychologique fort : Metabase rend la data moins intimidante, ce qui facilite l’adoption. En contrepartie, sa philosophie est clairement “simple d’abord”. Dès que l’on cherche une gouvernance avancée ou des workflows complexes de validation, certaines limites apparaissent. Ce n’est pas un défaut, mais un positionnement assumé.

Là où Metabase est très bon

- Time to value rapide avec un premier reporting utile en peu de temps

- Accessibilité pour des profils non techniques, si les modèles sont préparés

- Déploiement flexible selon les contraintes de conformité et d’hébergement

Points à surveiller

- Recours au SQL sur des besoins plus avancés

- Gouvernance enterprise scale à tester tôt

- Standardisation des KPI indispensable pour éviter un shadow BI “plus joli”

Sécurité et conformité

Metabase met en avant une posture privacy first et communique sur un rapport SOC 2 Type II pour l’offre Metabase Cloud (selon le périmètre du rapport), un point utile dans les échanges avec les équipes sécurité et conformité. (Metabase)

Tableau : le champion de l’exploration visuelle

Tableau reste une référence dès que l’enjeu est l’exploration visuelle et le storytelling analytique. Comprendre, comparer, expliquer, convaincre : Tableau excelle dans ces usages, notamment en comité de direction.

En entreprise, l’outil fonctionne très bien avec des power users finance, data ou produit. Mais cette puissance a un coût organisationnel. Sans gouvernance, on se retrouve vite avec une prolifération de workbooks et de métriques proches mais non identiques. Une BI brillante, mais contestée. (Tableau)

Là où Tableau excelle

- Dataviz riche et interactive pour l’analyse exploratoire

- Storytelling efficace pour embarquer les décideurs

- Produit mature avec un écosystème largement éprouvé

Points à surveiller

- Industrialisation à grande échelle : organisation, publication, nettoyage

- Coûts de licences lors de la montée en charge

- Dépendance à des profils experts pour exploiter pleinement l’outil

Conformité SaaS

Pour Tableau Cloud, les éléments de conformité et d’audit sont accessibles via le portail Salesforce, avec des documents spécifiques par service. Tableau communique également sur des sujets comme la conformité PCI DSS, ce qui peut être déterminant dans certains secteurs.

Power BI : la BI “par défaut” quand Microsoft est partout

Microsoft Power BI devient souvent le choix naturel lorsque l’écosystème Microsoft est déjà en place : M365, Teams, Azure, parfois Fabric. La diffusion est fluide, les usages bien intégrés, et les frictions limitées pour les utilisateurs.

Le piège classique apparaît quand l’organisation confond facilité de publication et facilité de gouvernance. Sans cadre clair, les rapports se multiplient et les KPI divergent. Résultat : plus personne ne sait quel chiffre est le bon. Power BI est puissant, mais exige une vraie discipline de modélisation. (Microsoft Learn)

Là où Power BI est très fort

- Diffusion large et adoption rapide dans l’écosystème Microsoft

- Chaîne data complète avec Power Query et modèles sémantiques

- Capacité à industrialiser un reporting structuré à l’échelle

Point crucial : la RLS en production

Un point souvent découvert trop tard : dans Power BI Service, la Row Level Security s’applique aux utilisateurs en rôle Viewer, mais pas aux Admins, Members ou Contributors d’un workspace. Accorder trop de droits “pour dépanner” peut neutraliser la sécurité sans s’en rendre compte. Un sujet à cadrer dès le POC. Et plus largement, il est indispensable de cadrer les rôles de workspace ainsi que les permissions Build, Read et Write sur les datasets, en tenant compte des modes de diffusion (Apps, partage, Publish to web) et des scénarios techniques comme DirectQuery, Import ou l’usage de service principals.

Comment choisir : une méthode simple, défendable, et vraiment utile

Voici la version “comex + IT + data office”. L’objectif n’est pas de faire joli sur un slide, mais de décider vite, avec une méthode compréhensible et défendable dans le temps.

- Définissez vos use cases et ce que vous voulez piloter : décisions attendues, KPI associés, fréquence de suivi et équipes concernées. Sans ce cadre, même le meilleur outil BI reste décoratif.

- Cartographiez les profils d’utilisateur : lecteur, explorateur, analyste, admin, ainsi que le niveau d’autonomie attendu pour chacun. Une BI efficace n’offre pas la même liberté à tout le monde, et c’est volontaire.

- Éliminez les outils incompatibles avec vos contraintes dès le départ : hébergement cloud ou on prem, exigences de sécurité, connecteurs nécessaires, capacité à monter en charge. Ce tri évite de perdre du temps sur des options irréalistes.

- Faites un POC sur vos données, pas sur une démo éditeur. Testez au moins deux scénarios représentatifs : un cas simple et un cas volontairement “pénible”. C’est souvent ce second scénario qui révèle les vrais coûts et limites.

- Mesurez l’adoption et la gouvernance : qualité du modèle, vitesse de delivery, diminution des exports manuels, niveau de confiance dans les chiffres. Si ces indicateurs ne progressent pas, l’outil n’est pas le bon, ou il est mal cadré.

Pour industrialiser sans perdre l’adhésion, la clé reste la phase produit : penser, construire, déployer. C’est précisément l’esprit de délivrer de la valeur : ancrer la BI dans le quotidien, avec des méthodes d’industrialisation adaptées à l’exploitation, pas uniquement à la phase projet.

Et si vous avez un chantier d’architecture, les choix de cloud technologies deviennent structurants. Performance, coûts, résilience et sécurité se jouent souvent à ce niveau, bien avant la sélection finale du logiciel BI.

Un dernier point de conformité, souvent sous-estimé et pourtant critique : lorsqu’on vous parle de SOC 2, assurez vous de bien comprendre ce que couvre réellement un rapport SOC 2 (sécurité, disponibilité, confidentialité, intégrité du traitement).

AICPA propose une documentation claire sur le périmètre et les exigences d’un examen SOC 2, utile pour éviter les malentendus en comité risk ou compliance.

Enfin, pour durcir concrètement vos environnements, les CIS Benchmarks fournissent des recommandations de configuration précises, largement utilisées en entreprise pour renforcer les pratiques de sécurité opérationnelle.

Conclusion

Sigma, Qlik, Metabase, Tableau et Power BI sont tous de bons outils… dans le bon contexte. La différence se joue rarement sur une fonctionnalité “waouh”. Elle se joue sur la gouvernance, la capacité à faire évoluer le décisionnel sans douleur et, surtout, sur l’adoption côté métiers.

Si l’on résume sans simplifier à l’excès : Sigma est très cohérent dans des environnements warehouse et cloud bien structurés ; Qlik est solide pour concilier exploration et contrôle à l’échelle ; Metabase brille par sa rapidité de mise en œuvre ; Tableau excelle en exploration visuelle et en storytelling ; Power BI s’impose par sa capacité de diffusion dans l’écosystème Microsoft.

Au final, le bon outil BI est celui qui vous aide à identifier les décisions clés, à les piloter dans la durée et à éviter de réinventer la vérité à chaque réunion. La technologie compte, bien sûr. Mais c’est l’alignement entre usages, gouvernance et architecture qui fait la différence.

FAQs

Quels sont les critères pour choisir le bon outil de BI ?

Pour choisir solution BI pertinente, commencez par le métier, pas par la technologie. Identifiez les décisions à piloter, la maturité des utilisateurs, les sources de données à connecter et les exigences de reporting.

Ensuite seulement, évaluez les critères techniques : architecture BI, performances, scalabilité, sécurité, gouvernance et coût total de possession. Un bon logiciel BI est celui qui s’intègre à votre contexte réel, pas celui qui coche le plus de cases sur une fiche produit.

Comment choisir la meilleure solution de BI pour les utilisateurs ?

Le point clé est l’adéquation entre l’outil et les profils d’usage. Analystes, managers et équipes opérationnelles n’attendent pas la même chose d’un outil de business intelligence.

Une bonne solution doit proposer une expérience intuitive, des tableaux de bord personnalisables, des capacités de self service encadrées et un reporting automatisé. L’objectif reste le même : faciliter l’adoption et accélérer la prise de décision, sans créer de dépendance excessive à l’équipe data.

Quels sont les avantages d’un outil de business intelligence et d’un logiciel BI ?

Un outil de business intelligence permet de centraliser les données, d’automatiser le reporting et de fiabiliser les indicateurs partagés.

Les logiciels BI apportent en plus des capacités d’analyse avancée, de datavisualisation et d’intégration de multiples sources de données. Bien utilisés, ils transforment la donnée en levier de pilotage opérationnel et stratégique.

Comment faire le bon choix entre plusieurs logiciels BI et solutions de BI ?

Comparer des fonctionnalités ne suffit pas. Pour choisir outils BI de manière rationnelle, il est essentiel de tester les solutions dans votre contexte réel.

Réalisez des POC sur vos propres données, impliquez les utilisateurs clés et mesurez des critères concrets : qualité du modèle, facilité d’évolution, gouvernance, adoption et ROI attendu. C’est souvent là que les différences apparaissent clairement.

Comment choisir un outil de BI adapté aux PME ?

Pour les PME, la priorité est d’aller vite sans se suréquiper. Un outil BI simple à déployer, avec un modèle de licence lisible, des connecteurs standards et une administration légère est souvent le meilleur choix.

L’enjeu est d’obtenir rapidement de la valeur, tout en conservant la possibilité d’évoluer si les usages et la volumétrie augmentent.

Lors du choix d’un outil, quelles sources de données et intégrations faut-il identifier ?

Commencez par les sources critiques : ERP, CRM, bases de données, fichiers et API. Vérifiez que le logiciel BI supporte ces connexions et les formats nécessaires.

La capacité à agréger, nettoyer et rafraîchir automatiquement les données est essentielle pour garantir des tableaux de bord fiables et éviter un reporting manuel chronophage.

Quelles fonctionnalités de sécurité et de gouvernance rechercher dans un logiciel de business intelligence ?

Un outil de BI fiable doit proposer un contrôle d’accès granulaire, une gestion des rôles, le chiffrement des données, des mécanismes d’audit et la conformité aux exigences réglementaires.

La gouvernance ne se limite pas à la sécurité : traçabilité des transformations, qualité des données et définitions partagées des KPI sont tout aussi déterminantes.

Comment piloter l’adoption et la formation des utilisateurs pour garantir le succès de la solution BI ?

L’adoption ne se décrète pas. Elle se pilote. Cela passe par des formations adaptées aux profils, des référents métiers, des supports concrets et des ateliers basés sur des cas réels.

Mesurer l’usage, analyser les retours et ajuster les tableaux de bord permet de s’assurer que l’outil BI devient un réflexe quotidien, au service de la décision.

.svg)