Si vos équipes débattent encore de la « bonne définition » du chiffre d’affaires, le diagnostic est déjà posé. Le problème ne vient pas de vos outils, ni même de vos bases de données. Il vient de l’absence d’un langage commun enitre la donnée et le métier.

Les couches sémantiques et au singulier la couche sémantique répondent précisément à ce défi. Elle traduisent des tables techniques et des types de données hétérogènes en concepts métier stables, compréhensibles et réutilisables, aussi bien en BI qu’en IA.

Dans les missions menées par Eulidia, c’est souvent ce chaînon qui sécurise la décision sans freiner l’innovation.

À première vue, le sujet peut sembler relever du reporting. En réalité, il touche à des enjeux bien plus structurants : la confiance dans les chiffres, la maîtrise des coûts ou encore la vitesse d’exécution. Une couche de données sémantiques bien conçue permet de réconcilier données et décisions, même dans des organisations complexes. Et lorsque l’IA entre en jeu, le moindre flou devient immédiatement visible.

Couche sémantique : la réponse simple à un problème très cher

Une couche sémantique sert à exprimer les données en langage métier. Elle formalise les entités, les dimensions, les règles de calcul, les règles d’accès et les relations entre les données. Autrement dit, elle donne du sens à ce qui n’est, à l’origine, qu’un empilement de tables et de colonnes.

Elle ne remplace ni vos pipelines, ni votre entrepôt, ni votre Data Lake. Elle s’appuie sur eux. Son rôle est différent : rendre la donnée lisible et exploitable, sans réécriture permanente de la logique métier dans chaque outil ou chaque usage.

Le déclic survient souvent lorsque les versions d’un même indicateur se multiplient. Un dashboard finance calcule le « net revenue » d’une manière, un dashboard e-commerce applique une autre règle, puis l’équipe IA reprogramme encore cet indicateur dans un notebook avec une autre règle de gestion. Les bases de données sont pourtant les mêmes, mais le sens diverge. Résultat : des discussions interminables, des correctifs en cascade et un risque croissant d’erreurs décisionnelles.

C’est précisément ce que la couche sémantique vient éliminer. Elle fixe un référentiel clair et partagé. Plus de loterie sur les chiffres. Plus de réinterprétation locale.

Du concept à l’objet exploitable dans les architectures modernes

Contrairement à une idée répandue, la couche sémantique n’est pas un idéal théorique réservé à des architectures parfaites. Elle existe déjà sous forme d’objets concrets dans les plateformes data modernes et s’intègre directement aux bases de données utilisées au quotidien par les entreprises.

C’est précisément le cas de Snowflake, qui décrit ses semantic views comme des objets permettant de définir des tables logiques, leurs relations et des métriques prêtes à l’analyse. Ces vues reposent sur les données existantes, mais introduisent un niveau de lecture métier partagé, indépendant des usages BI ou IA.

On est bien au-delà d’un simple artefact de reporting. Il s’agit d’un véritable Modèle de données sémantiques, positionné au-dessus de la couche technique, capable d’unifier les définitions tout en restant aligné avec les types de données et les contraintes physiques des plateformes.

Ce point est clé. La couche de données sémantiques ne cherche pas à masquer la complexité, mais à la canaliser. Elle devient un contrat explicite entre producteurs et consommateurs de données. Un contrat que la BI peut interroger, que les cas d’usage IA peuvent exploiter et que les équipes peuvent faire évoluer sans redéfinir le sens à chaque projet.

Et au fond, la vraie question n’est pas de savoir si la couche sémantique est utile. C’est de comprendre combien son absence coûte déjà, en arbitrages ralentis, en modèles IA fragilisés et en décisions prises sur des définitions mouvantes.

Comprendre la couche sémantique : où elle se place et pourquoi ça change tout

Dans une architecture data moderne, le chemin est bien connu. On part de sources multiples ERP, CRM, web, capteurs. On ingère, on transforme, on historise. Puis on expose les données.

La couche sémantique intervient précisément à ce moment charnière où l’on cesse de manipuler des tables pour commencer à parler métier.

C’est elle qui permet d’adresser des consommateurs très différents avec un langage commun. Outils de BI, APIs, assistants analytiques, agents IA, équipes métier. Tous s’appuient sur la même couche de données sémantiques, sans avoir à réinterpréter la logique à chaque usage.

Ce positionnement explique pourquoi elle résout des frictions que l’ETL ou l’ELT ne peuvent pas régler seuls. Les transformations physiques améliorent la qualité, la structure et la performance des bases de données. Mais elles ne suffisent pas à figer le sens des métriques. Or, dans les grandes organisations, ce sont justement ces écarts de signification qui génèrent le plus de coûts cachés.

Une brique qui décloisonne sans rigidifier

La couche sémantique joue aussi un rôle clé dans la rationalisation des stacks analytiques. Lorsqu’une même logique de calcul alimente un outil analytics, un outil de ETL et un agent IA, les doublons diminuent fortement.

On ne parle pas ici de centralisation autoritaire, mais d’un socle commun. Une brique qui simplifie la gouvernance sans étouffer l’autonomie des équipes. Et cet équilibre est rare.

Le Modèle de données sémantiques agit comme un point d’alignement. Il encapsule les règles métier tout en restant compatible avec la diversité des types de données et des usages.

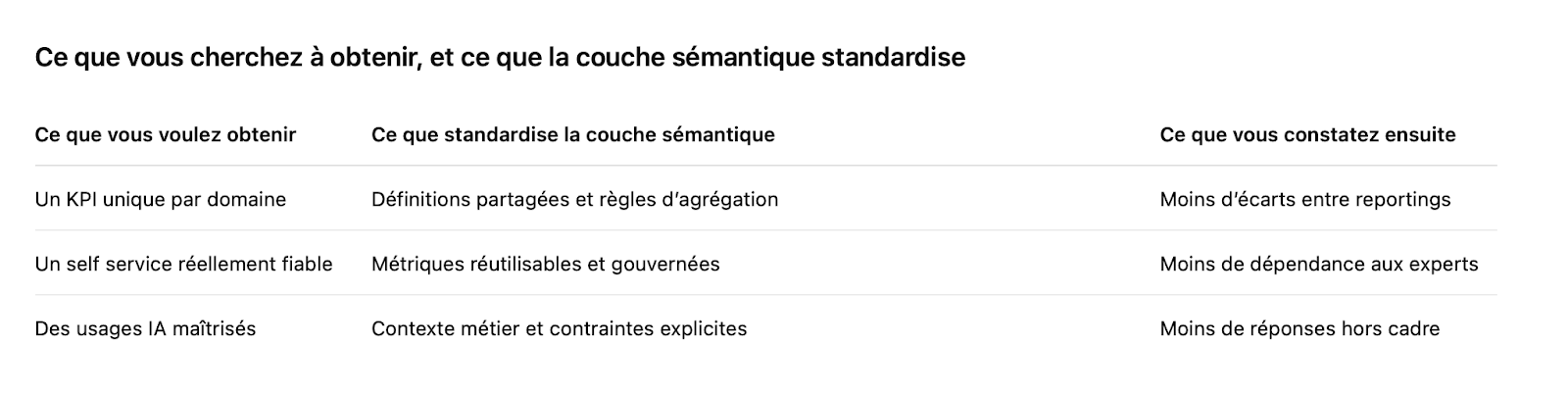

Les bénéfices : du KPI stable à une IA plus fiable

Pour la BI, le gain est immédiatement visible. Plus de cohérence. Moins de formules copiées collées. Moins de filtres implicites. Les analystes gagnent en self service parce qu’ils s’appuient sur des définitions validées, partagées et documentées, plutôt que sur des interprétations locales.

Pour l’IA, l’impact est plus subtil, mais souvent plus structurant. Un modèle ou un assistant est très performant pour produire une réponse, même lorsque la question est ambiguë. La couche sémantique apporte alors le cadre nécessaire. Quelles dimensions sont autorisées? Quels agrégats sont légitimes. Quelles jointures sont sûres. Autrement dit, elle réduit le risque de réponses techniquement correctes mais fonctionnellement fausses.

À l’échelle de l’entreprise, les effets se mesurent rapidement. Moins de rework. Moins de shadow BI. Moins de décisions prises sur des définitions mouvantes.

Dans l’approche produit portée par Eulidia, l’objectif est clair. Ancrer la data dans le quotidien des utilisateurs, avec une clarté fonctionnelle assumée et un haut niveau d’industrialisation.

Modèle de données sémantiques : concevoir pour décider, pas pour stocker

Un Modèle de données sémantiques efficace ne commence pas par les tables. Il commence par les décisions. Qu’essaie-t-on réellement de piloter ? Où se prennent les arbitrages ? Et à partir de quels signaux ?

Ce raisonnement amène naturellement aux objets métier clés : client, contrat, commande, produit, site, canal. L’objectif n’est pas d’empiler des dimensions, mais de sélectionner celles qui expliquent réellement la performance. À défaut, on construit un musée de KPIs. Impressionnant visuellement, beaucoup moins utile opérationnellement.

La méthode la plus robuste repose sur un noyau volontairement restreint. Dix à vingt métriques non négociables, documentées, testées et versionnées. Ce socle devient la référence commune. Ensuite seulement, on élargit. C’est typiquement ce que l’on structure dans une démarche de data stratégie : prioriser les usages, clarifier les owners et organiser une trajectoire d’enrichissement maîtrisée.

Rendre explicites les règles que la donnée cache bien

Les difficultés apparaissent rarement sur les cas simples. Elles surgissent dès que les données deviennent complexes. Temporalité. Multi-devises. Hiérarchies produits. Changements de périmètre. Fusions d’entités. Granularités disjointes entre sources.

Dans ces situations, les équipes se trompent souvent en silence. Les chiffres restent plausibles, mais le sens dérive. C’est précisément là qu’une couche sémantique bien conçue fait la différence. Elle formalise ces règles. Elle les rend visibles, testables et auditables. Et surtout, elle évite que chaque outil ou chaque équipe réinterprète la logique à sa manière.

Intégration : relier data warehouse, usages BI et IA, sans chaos

L’intégration est le moment où tout se joue. Les transformations sont en place. Les tables sont propres. Les bases de données analytiques sont fiables. Pourtant, tant que la signification reste disséminée dans les dashboards et les notebooks, le même travail est refait partout.

La couche de données sémantiques permet de rompre ce cycle. Elle expose une logique unique, interrogeable via SQL, APIs ou connecteurs, et consommable aussi bien par la BI que par les cas d’usage IA. Les types de données et les contraintes techniques restent maîtrisés, mais le sens devient partagé.

Plusieurs acteurs structurent aujourd’hui cette industrialisation. dbt met en avant une définition centralisée des métriques, avec une promesse simple : définir une fois, faire confiance partout. Sigma insiste de son côté sur des modèles de données réutilisables, gouvernés et versionnés, conçus pour renforcer la cohérence métrique à l’échelle des organisations.

Gouvernance et adoption : cadrer sans ralentir

Sur le plan organisationnel, la réussite dépend d’un partage clair des rôles. Les data engineers garantissent la robustesse. Les data product owners portent les définitions métier. Les équipes sécurité définissent et appliquent les règles d’accès.

Dans une trajectoire de transformation data, ce passage à l’échelle se formalise justement à l’intersection de la culture, de l’organisation et des briques technologiques.

Concrètement, quelques principes structurants font la différence :

- Fixer un dictionnaire de métriques par domaine avec un owner métier identifié.

- Définir explicitement les règles d’agrégation et les jointures autorisées.

- Versionner la couche sémantique, avec CI CD et tests sur les métriques critiques.

- Appliquer les droits RLS et CLS au plus près des concepts métier.

- Brancher les outils BI et les APIs sur les mêmes définitions.

- Mesurer l’adoption par des indicateurs simples : réutilisation des métriques, écarts de KPI, volume de rework.

Au final, le modèle de données sémantiques n’est pas une surcouche abstraite. C’est un accélérateur de décisions fiables. Et dans un contexte où la BI et l’IA cohabitent, c’est souvent lui qui fait la différence entre une plateforme qui produit des chiffres et une organisation qui sait vraiment piloter.

Analyses avancées : quand la sémantique devient le socle des agents

Les « analyses avancées » sont souvent présentées comme un ensemble homogène. En pratique, elles recouvrent des réalités très différentes : data science, prévision, optimisation, et désormais assistants conversationnels et agents décisionnels. Leur point commun n’est pas la sophistication algorithmique, mais leur dépendance absolue au sens.

Un agent qui interroge directement des bases de données brutes peut produire des réponses rapides. Parfois même très convaincantes. Le problème est ailleurs. Il ignore les conventions métier, les règles d’agrégation implicites et les limites d’usage. Les réponses sont techniquement correctes, mais fonctionnellement risquées.

C’est précisément là que la couche sémantique change la donne. L’agent ne navigue plus à l’aveugle. Il interroge des objets connus, des métriques validées, des dimensions gouvernées. Il s’appuie sur un modèle de données sémantiques qui explicite les relations, les règles et les contraintes d’accès. Le champ d’exploration est volontairement cadré, sans être artificiellement bridé. Ce cadrage fonctionne en complément des mécanismes de gouvernance, de contrôle d’accès, d’audit et de traçabilité existants, et non en substitution.

Ce cadrage est d’autant plus critique dans un contexte européen. Les exigences de protection des données, de traçabilité et de séparation des usages imposent un contrôle fin des accès et des périmètres. Une couche de données sémantiques permet justement d’aligner les usages IA avec ces contraintes, sans multiplier les implémentations spécifiques.

Un bénéfice décisif, souvent sous estimé : la maintenabilité

Au-delà de la fiabilité des réponses, la sémantique apporte un avantage moins visible, mais absolument déterminant : la maintenabilité.

Lorsque la logique métier est centralisée dans une couche sémantique, un changement de source, de structure ou de périmètre se corrige à un seul endroit. Pas dans quinze dashboards, plusieurs notebooks et différents assistants.

C’est ce qui fait la différence entre une plateforme qui subit ses usages avancés et une plateforme capable de les industrialiser. Les équipes passent moins de temps à éteindre des incendies de reporting et peuvent continuer à délivrer de la valeur en production, de façon itérative et maîtrisée.

Dans ce contexte, la couche de données sémantiques ne joue plus un rôle de support. Elle devient une infrastructure de confiance. Et à mesure que les agents IA prennent place dans la chaîne de décision, ce socle conditionne directement la capacité de l’entreprise à évoluer sans se fragiliser.

Conclusion : unifier BI et IA, c’est d’abord unifier le sens

Les couches sémantiques ne sont pas un luxe d’architecte ni une sophistication réservée aux environnements très matures. C’est un choix de pilotage. Un choix qui consiste à rendre les définitions explicites, partagées et auditables, avant de multiplier les usages.

Dans les organisations qui industrialisent l’IA, cette décision est souvent déterminante. Elle marque la différence entre une succession de POC prometteurs mais isolés et un véritable système de décision, robuste, reproductible et exploitable à l’échelle.

S’il ne fallait retenir qu’un principe, ce serait celui-ci. Positionner la couche sémantique là où se rencontrent la BI, l’IA et la sécurité. Là où les bases de données, les types de données et les règles métier cessent d’être interprétés localement pour devenir un socle commun. C’est à ce niveau que le modèle de données sémantiques prend toute sa valeur.

S’appuyer sur une trajectoire cloud centric, avec des données unifiées, des usages simplifiés et des coûts maîtrisés, permet ensuite d’outiller cette sémantique sans la figer. Les technologies cloud offrent aujourd’hui les briques nécessaires pour articuler performance, gouvernance et évolutivité.

Au final, unifier la BI et l’IA n’est pas qu’une question de plateforme, c’est une question de sens. Et ce sens, lorsqu’il est bien posé, conditionne directement la qualité des décisions prises par l’organisation.

FAQs

Qu’est ce qu’une couche sémantique et comment simplifie-t-elle l’accès aux données ?

Une couche sémantique est une abstraction placée au-dessus des sources et des systèmes de stockage de données. Son rôle est de traduire la complexité technique des bases de données en concepts métier compréhensibles et stables.

Elle fournit des définitions cohérentes de métriques, de dimensions et de règles de calcul, afin que les équipes data comme les utilisateurs métier puissent accéder aux données de façon fiable, sans dépendre de la structure physique sous-jacente.

Quels sont les avantages d’une couche sémantique pour la gouvernance des données ?

La couche sémantique permet d’appliquer des règles de gouvernance centralisées tout en restant proche des usages.

En définissant un référentiel commun de métriques et de relations, elle améliore la cohérence des données, facilite la traçabilité entre sources et usages, et réduit les risques liés à la dispersion des logiques métier dans les pipelines et les outils analytiques.

Qu’est ce qu’une couche sémantique dans un entrepôt de données et quel est son rôle ?

Dans un entrepôt de données, la couche de données sémantiques se situe entre les transformations ETL ou ELT et les produits de données consommés par les métiers.

Elle ne remplace pas les transformations physiques, mais les complète en standardisant le sens. Elle expose des objets analytiques cohérents à partir des données transformées, prêts pour l’analyse, tout en préservant la qualité et la lisibilité après chaque pipeline.

Comment concevoir des modèles de données adaptés aux besoins des équipes ?

Un modèle de données sémantiques décrit les ensembles de données, leurs relations, les définitions métier et le langage commun de l’organisation.

Sa conception repose sur une collaboration étroite entre ingénieurs de données, équipes métier et responsables produits. L’objectif est de refléter les processus réels, de faciliter l’analyse et de permettre un accès intuitif aux données, sans exposer inutilement la complexité technique.

Sémantique de données : quel impact sur la qualité et la cohérence ?

La sémantique de données impose des standards partagés qui limitent les interprétations multiples d’un même indicateur.

En centralisant les définitions dans une couche sémantique, on réduit les écarts entre reportings, on améliore la cohérence entre systèmes et on renforce durablement la qualité des données, y compris à grande échelle.

Quelle est la différence entre une couche sémantique et les sources de données sous-jacentes ?

La couche sémantique ne remplace ni les sources de données ni les systèmes de stockage. Elle les fédère.

Elle crée une abstraction au-dessus des structures physiques pour exposer des vues métier cohérentes, capables d’unifier des volumes de données provenant de différentes bases de données, entrepôts ou systèmes opérationnels.

Une couche sémantique permet-elle de transformer les données et d’améliorer les pipelines ?

Oui, dans une certaine mesure. La couche sémantique s’intègre aux pipelines existants pour appliquer des transformations standardisées et conformes au modèle sémantique défini.

Elle garantit que les règles métier sont respectées de bout en bout, ce qui réduit le travail redondant, sécurise les usages et accélère la mise à disposition de produits de données fiables.

Comment maintenir la flexibilité d’un modèle sémantique face à la complexité et aux volumes ?

Pour rester flexible, un modèle sémantique doit être modulaire, versionné et gouverné.

L’utilisation d’abstractions claires, de définitions évolutives et d’une gouvernance active permet d’absorber l’arrivée de nouvelles sources, de nouveaux types de données ou de nouveaux usages, sans remettre en cause la cohérence globale.

.svg)